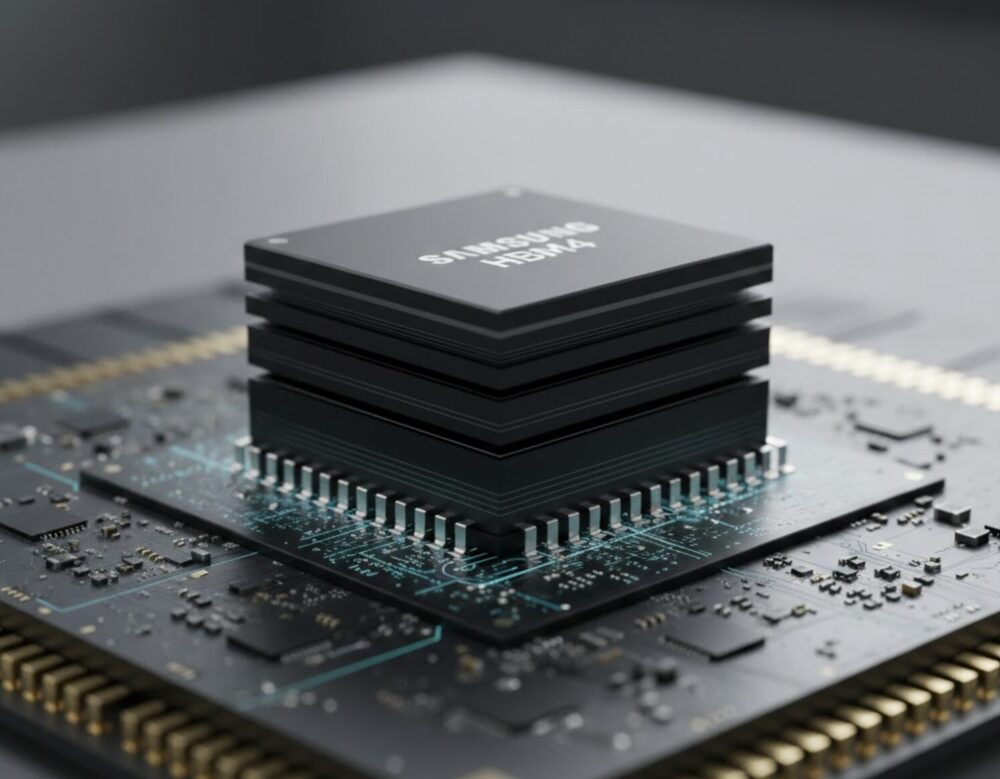

Samsungのメモリ事業にとって、非常に大きなニュースが入ってきました。これまでNVIDIAへのHBM(広帯域メモリ)供給で苦戦していた同社ですが、次世代AIチップ「Vera Rubin」向けの「HBM4」において、初期サプライヤーの座を勝ち取った模様です。評価されたポイントは、競合を上回る「転送速度」と、自社工場で製造を完結できる「安定した供給能力」です。本稿では、AIインフラの進化を加速させるSamsung製HBM4の強みと、市場への影響について解説します。

Samsungのメモリ事業にとって、非常に大きなニュースが入ってきました。これまでNVIDIAへのHBM(広帯域メモリ)供給で苦戦していた同社ですが、次世代AIチップ「Vera Rubin」向けの「HBM4」において、初期サプライヤーの座を勝ち取った模様です。評価されたポイントは、競合を上回る「転送速度」と、自社工場で製造を完結できる「安定した供給能力」です。本稿では、AIインフラの進化を加速させるSamsung製HBM4の強みと、市場への影響について解説します。

業界標準を上回る「11Gbps超」の転送速度

最大の注目点は、Samsung製HBM4モジュールが達成した圧倒的なスピードです。業界の標準規格(JEDEC)を大幅に上回る「11Gbps以上」のピン速度を実現しており、これがNVIDIAの次世代チップで求められる厳しい条件をクリアしました。

自律的に動作するエージェントAIの普及に伴い、メモリのデータをやり取りする帯域幅には、これまで以上の性能が求められています。Samsungは以前、NVIDIAの品質テストで採用が見送られるという苦い経験をしましたが、今回のHBM4ではその雪辱を果たしました。速度と帯域幅において競合他社より優れた性能を示したことが、今回の採用における決定打となったようです。

自社「4nmプロセス」での一貫製造による安定供給

性能だけでなく、製造体制における戦略的なメリットも見逃せません。HBM4のような積層メモリでは、土台となる「ロジック・ベースダイ」の製造が重要になりますが、Samsungはこれを自社の「4nmプロセス」で製造しています。

競合であるSK HynixやMicronが、ベースダイの製造をTSMCなどの外部企業に委託する計画であるのに対し、Samsungはメモリから土台部分までをすべて自社内で製造できます。これにより、外部工場の空き状況に左右されることなく、NVIDIAの急ピッチな生産スケジュールに合わせて製品を納入可能です。「Vera Rubin」の量産を急ぐNVIDIAにとって、この安定した供給体制は非常に魅力的なはずです。

AIメモリ市場でのSamsungの巻き返し

報道によると、Samsung製HBM4の供給は早ければ来月(2026年2月)にも開始され、6月には製品ラインナップに組み込まれる見通しです。さらに、8月からの顧客向け出荷、そしてGTC 2026での展示へと続く計画が進んでいます。

かつての不採用から一転、最先端の「Vera Rubin」で主要サプライヤーの地位を取り戻したことは、Samsungの技術力が再びトップレベルに戻ったことを意味します。単なる「代わりの品」ではなく、その性能を評価されて選ばれたSamsung製HBM4は、今後のハイエンドAIサーバー市場において、欠かせない存在となるはずです。